萬字長文詳解:國外主流科技公司的AI倫理實(shí)踐

曹建峰 騰訊研究院高級研究員

一、倫理原則

微軟致力于以人為本地推動AI技術(shù)發(fā)展,在AI倫理方面提出公平、安全可靠、隱私保障、包容、透明、負(fù)責(zé)六大原則。

二、治理機(jī)構(gòu)

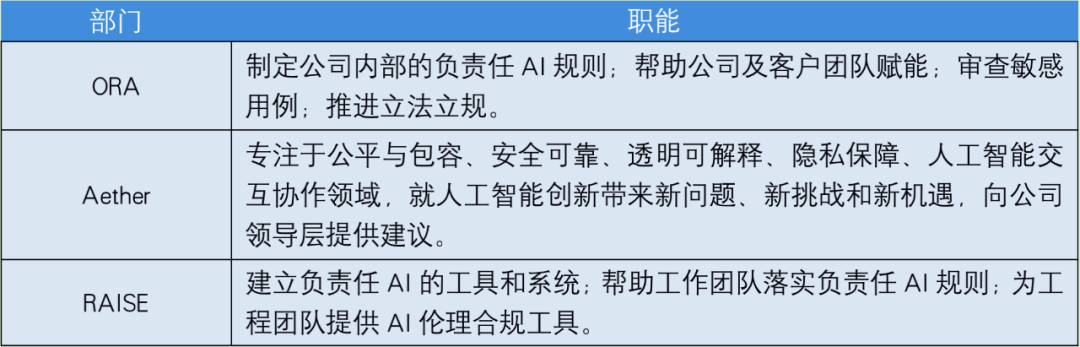

微軟主要有三個內(nèi)設(shè)機(jī)構(gòu)負(fù)責(zé)AI倫理踐行方面的事務(wù)。它們分別是負(fù)責(zé)任人工智能辦公室(Office of Responsible AI,以下簡稱ORA),人工智能、倫理與工程研究委員會(AI and ethics in engineering and research committee,以下簡稱Aether committee),以及負(fù)責(zé)任AI戰(zhàn)略管理團(tuán)隊(duì)(Responsible AI Strategy in Engineering,以下簡稱RAISE)。

ORA主要有四個職能:制定公司內(nèi)部的負(fù)責(zé)任AI規(guī)則;團(tuán)隊(duì)賦能,幫助公司以及客戶落實(shí)AI倫理規(guī)則;審查敏感用例,確保微軟AI原則在開發(fā)和部署工作中得到實(shí)施;推進(jìn)立法、規(guī)范、標(biāo)準(zhǔn)的制定,確保人工智能技術(shù)有助于提升社會福祉。通過這些行動,人工智能辦公室將微軟的AI倫理原則付諸實(shí)踐。

Aether于2017年設(shè)立,該委員會由產(chǎn)品開發(fā)、研究員、法律事務(wù)、人力資源等部門的負(fù)責(zé)人組成,專注于公平與包容、安全可靠、透明可解釋、隱私保障、人工智能交互協(xié)作領(lǐng)域,積極制定內(nèi)部政策,并決定怎樣負(fù)責(zé)任地處理出現(xiàn)的問題。當(dāng)部門內(nèi)部出現(xiàn)問題時,委員會以研究、反思和建議來回應(yīng),這些針對特定案例的建議可能演變?yōu)楣就ㄓ玫睦砟睢⒄吆蛯?shí)踐。

RAISE旨在使負(fù)責(zé)任AI的要求整合到團(tuán)隊(duì)日常開發(fā)過程中。其有三項(xiàng)職能:建立負(fù)責(zé)任AI的工具和系統(tǒng),幫助公司及客戶實(shí)現(xiàn)AI倫理落地;幫助工作團(tuán)隊(duì)落實(shí)負(fù)責(zé)任AI規(guī)則,將負(fù)責(zé)任AI的要求整合到日常工作中;為工程團(tuán)隊(duì)提供合規(guī)工具,以監(jiān)控和執(zhí)行負(fù)責(zé)任AI規(guī)則的要求。

三、AI倫理的技術(shù)解決方案

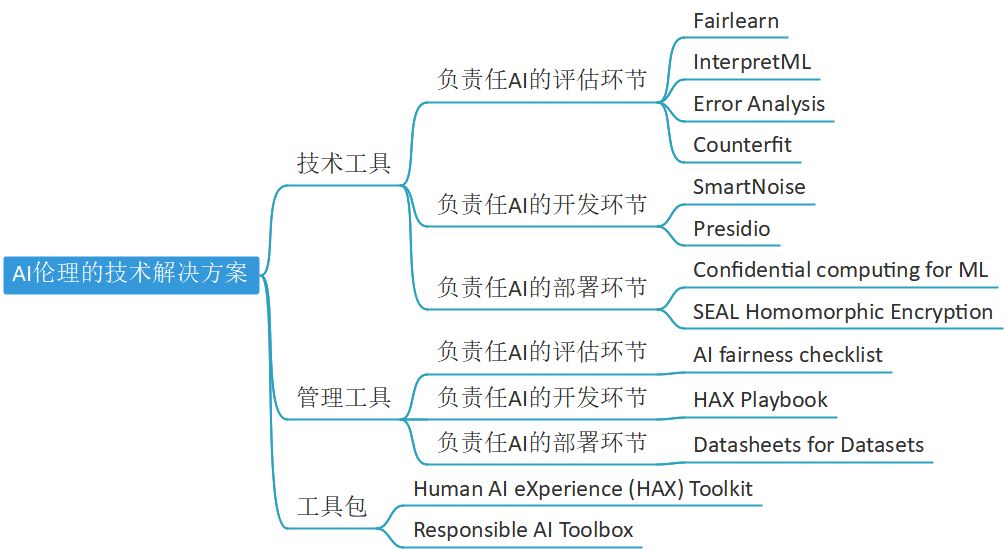

針對AI倫理實(shí)踐,微軟給出了一系列的技術(shù)解決方案。這些技術(shù)解決方案包括了貫穿整個AI生命周期的技術(shù)工具(Technology tools)和管理工具(Management tools),同時,還包括了按照應(yīng)用場景將需求特性集成到AI系統(tǒng)中的工具包(Toolkit)。

1 / 技術(shù)工具

(1)評估

Fairlearn: 一個python工具包/庫,用于評估給定AI模型在一系列公平性指標(biāo)上的得分,如”預(yù)測個人收入“的模型是否在男性客戶群體中的預(yù)測效果比女性群體更好,進(jìn)而發(fā)現(xiàn)可能的模型歧視,為模型的改進(jìn)提供公平性約束。

InterpreteML:一個python工具包/庫, 集成了一系列XAI(可解釋AI)的前沿方法。既允許用戶從頭訓(xùn)練一個可解釋的“玻璃箱”模型,還能幫助人們理解/解釋某些給定的”黑箱”模型。

Error Analysis: 一個python工具包/庫,提供一系列對于主流AI模型進(jìn)行“錯誤分析”的功能。包括但不限于為誤分類樣本建立可視化熱力圖,構(gòu)建全局/局部解釋,因果干涉等分析,幫助人們更好探索數(shù)據(jù)、認(rèn)識模型。

Counterfit: 一個基于命令行的通用檢測工具,用于測試給定的AI系統(tǒng)在作為開源平臺時的穩(wěn)定性和安全性。

(2)開發(fā)

SamrtNoise: 一系列基于“差分隱私”的前沿AI技術(shù):通過特定方式在AI模型訓(xùn)練過程中添加噪音,確保開發(fā)者在開發(fā)過程中、所用敏感隱私數(shù)據(jù)不會泄露。

Presidio: 一個python工具包/庫。能幫助使用者高效地識別、管理并模糊大數(shù)據(jù)中的敏感信息,比如自動識別文本中的地址、電話等。

(3)部署

Confidential computing for ML:在微軟云的系統(tǒng)上,通過機(jī)密計(jì)算等系統(tǒng)層面的安全手段,保證模型與敏感數(shù)據(jù)的絕對安全。

SEAL Homomorphic Encryption:使用開源同態(tài)加密技術(shù),允許在加密數(shù)據(jù)上執(zhí)行計(jì)算指令,同時防止私有數(shù)據(jù)暴露給云運(yùn)營商。

2 / 管理工具

AI fairness checklist:AI fairness checklist研究項(xiàng)目探討如何設(shè)計(jì)人工智能道德清單,以支持更公平的人工智能產(chǎn)品和服務(wù)的發(fā)展。研究小組與清單的使用者——人工智能從業(yè)人員協(xié)作,征求他們的意見,形成人工智能的設(shè)計(jì)、開發(fā)和部署全生命周期的檢查清單。項(xiàng)目的首批研究已經(jīng)產(chǎn)生了一個與從業(yè)者共同設(shè)計(jì)的公平性清單,同時也形成了對組織和團(tuán)隊(duì)流程如何影響AI團(tuán)隊(duì)解決公平性危害的見解。

HAX Playbook:一個主動、系統(tǒng)地探索常見人工智能交互故障的工具。Playbook 列出了與人工智能產(chǎn)品應(yīng)用場景相關(guān)的故障,以便為開發(fā)者提供有效恢復(fù)的方法。Playbook 還提供了實(shí)用的指導(dǎo)和示例,以說明如何用較低的成本模擬系統(tǒng)行為,以便進(jìn)行早期用戶測試。

Datasheets for Datasets:機(jī)器學(xué)習(xí)社區(qū)目前沒有記錄數(shù)據(jù)集的標(biāo)準(zhǔn)化流程,這可能會導(dǎo)致高風(fēng)險領(lǐng)域的嚴(yán)重后果。為了解決這個差距,微軟開發(fā)了Datasheets for Datasets。在電子工業(yè)中,每一個組件,無論多么簡單或復(fù)雜,都有一個數(shù)據(jù)表(datasheet )來描述其操作特性、測試結(jié)果、推薦用途和其他信息。相應(yīng)的,每一個數(shù)據(jù)集(dataset)都應(yīng)該有一個記錄其動機(jī)、組成、收集過程、推薦用途等的數(shù)據(jù)表。Datasheets for Datasets將促進(jìn)數(shù)據(jù)集創(chuàng)建者和數(shù)據(jù)集消費(fèi)者之間的溝通,并鼓勵機(jī)器學(xué)習(xí)優(yōu)先考慮透明度和問責(zé)制。

3 / 工具包

Human AI eXperience(HAX)Toolkit:HAX Toolkit是一套實(shí)用工具,旨在幫助AI創(chuàng)造者,包括項(xiàng)目管理和工程團(tuán)隊(duì)等主體,在日常工作中采用這種以人為本的方法。

Responsible AI Toolbox:Responsible AI Toolbox涵蓋了錯誤分析(Error Analysis)、可解釋性(Interpretability)、公平性(Fairness)、負(fù)責(zé)任(Responsible)四個界面,增進(jìn)人們對AI系統(tǒng)的了解,使開發(fā)者、監(jiān)管機(jī)構(gòu)等相關(guān)人員能夠更負(fù)責(zé)任地開發(fā)和監(jiān)控 AI,并采取更好的數(shù)據(jù)驅(qū)動行動(data-driven actions)。

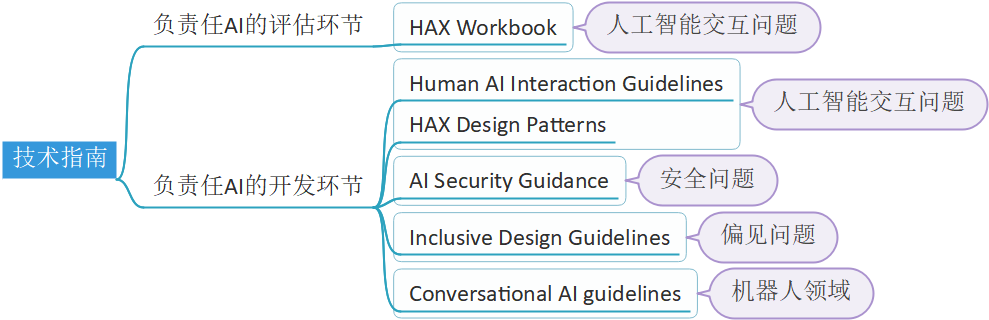

四、行動指南

為了能讓項(xiàng)目團(tuán)隊(duì)更好地貫徹AI原則,微軟公司發(fā)布了一系列行動指南(Guidelines),在項(xiàng)目開發(fā)過程中為團(tuán)隊(duì)提供具體的行動建議、解決方案,如“應(yīng)該收集哪些數(shù)據(jù)”、“應(yīng)該如何訓(xùn)練AI模型”等問題上。行動指南旨在為團(tuán)隊(duì)節(jié)省時間、提高用戶體驗(yàn)、貫徹AI倫理原則。行動指南不同于任務(wù)清單(checklist),或許并不適用于每一個應(yīng)用場景,也并非需要團(tuán)隊(duì)強(qiáng)制遵守,針對特殊情況、專門領(lǐng)域,會發(fā)布專用的行動指南。

微軟針對人工智能交互問題、安全問題、偏見問題、機(jī)器人開發(fā)領(lǐng)域問題,發(fā)布了6項(xiàng)行動指南,貫穿負(fù)責(zé)任AI的評估環(huán)節(jié)、開發(fā)環(huán)節(jié)。其中HAX Workbook、Human AI Interaction Guidelines以及HAX Design Patterns旨在幫助解決人工智能交互問題;AI Security Guidance針對人工智能可能帶來的安全威脅,提供解決方案;Inclusive Design Guidelines充分考慮了人類的多樣性,用于解決AI可能帶來的偏見問題;Conversational AI guidelines專注于機(jī)器人開發(fā)領(lǐng)域可能帶來的種種問題。

一、 倫理原則

谷歌從積極方面和消極方面規(guī)定了人工智能設(shè)計(jì)、使用的原則,將其作為公司和未來AI發(fā)展的基礎(chǔ)。該原則以“道德憲章”的地位,指導(dǎo)公司的AI研究以及AI產(chǎn)品中的開發(fā)和使用。同時谷歌也承諾,愿意隨著時間的推移而及時調(diào)整這些原則。具體來說,這些原則包括:

積極方面,人工智能的使用應(yīng)該:

(1)有利于增進(jìn)社會福祉;

(2)避免制造或強(qiáng)化歧視、偏見;

(3)以安全為目的的創(chuàng)新;

(4)對公眾負(fù)責(zé);

(5)納入隱私設(shè)計(jì)原則;

(6)堅(jiān)持科學(xué)卓越的高標(biāo)準(zhǔn);

(7)符合這些原則。

消極方面,公司不會在以下應(yīng)用領(lǐng)域設(shè)計(jì)或部署AI:

(1)造成或可能造成危害的技術(shù);

(2)對人造成傷害的武器或其他技術(shù);

(3)違反了國際公認(rèn)規(guī)范,收集或使用信息用于監(jiān)視的技術(shù);

(4)目的違反廣泛接受的國際法和人權(quán)原則的技術(shù)。

二、治理機(jī)構(gòu)

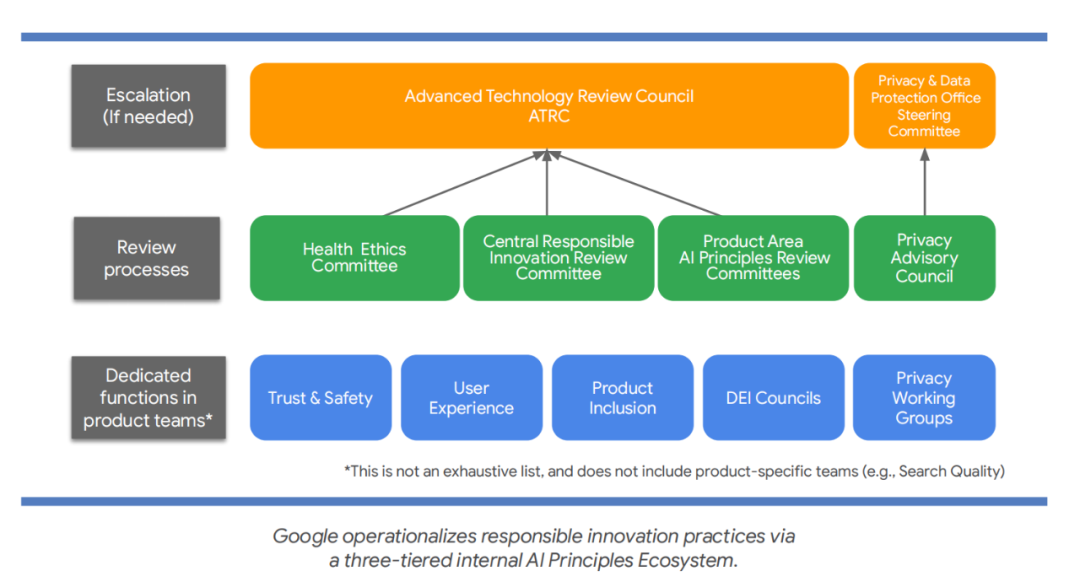

2018年,谷歌宣布人工智能原則的同時,成立了負(fù)責(zé)任創(chuàng)新中央團(tuán)隊(duì)(central Responsible Innovation team),當(dāng)初這個團(tuán)隊(duì)僅由6名員工組成。如今,團(tuán)隊(duì)規(guī)模已經(jīng)顯著擴(kuò)大,數(shù)百名谷歌員工構(gòu)成了數(shù)十個創(chuàng)新團(tuán)隊(duì),在人權(quán)、用戶體驗(yàn)研究、倫理、信任和安全、隱私、公共政策、機(jī)器學(xué)習(xí)等領(lǐng)域構(gòu)建了一個AI原則生態(tài)系統(tǒng)。谷歌通過這個內(nèi)部的AI原則生態(tài)系統(tǒng)來實(shí)施負(fù)責(zé)任AI的創(chuàng)新實(shí)踐,幫助谷歌技術(shù)開發(fā)人員將負(fù)責(zé)任AI落實(shí)到他們的工作當(dāng)中。這個生態(tài)系統(tǒng)的核心是一個三層的治理架構(gòu):

第一層是產(chǎn)品團(tuán)隊(duì),由專門負(fù)責(zé)用戶體驗(yàn)(UX)、隱私、信任和安全(T&S)等方面的專家組成,這些專家提供與人工智能原則相一致的專業(yè)知識。

第二層是專門的審查機(jī)構(gòu)和專家團(tuán)隊(duì)。由負(fù)責(zé)任創(chuàng)新中央團(tuán)隊(duì)(Central Responsible Innovation Review Committee)、隱私顧問委員會(Privacy Advisory Council)、衛(wèi)生倫理委員會(Health Ethics Committee)以及產(chǎn)品審查委員會(Product Area AI Principles Review Committees)四個部門組成。

(1)負(fù)責(zé)任創(chuàng)新中央團(tuán)隊(duì)(Central Responsible Innovation Review Committee)

該團(tuán)隊(duì)為整個公司的實(shí)施AI原則提供支持。公司鼓勵所有員工在整個項(xiàng)目開發(fā)過程中參與人工智能原則的審查。一些產(chǎn)品領(lǐng)域已經(jīng)建立了審查機(jī)構(gòu),以滿足特定的受眾和需求,如谷歌云(Google Cloud)中的企業(yè)產(chǎn)品、設(shè)備和服務(wù)(Devices and Services)中的硬件、谷歌健康(Google Health)中的醫(yī)學(xué)知識。

(2)隱私顧問委員會(Privacy Advisory Council)

該委員會負(fù)責(zé)審查所有可能存在潛在隱私問題的項(xiàng)目,包括(但不僅限于)與人工智能相關(guān)的問題。

(3)健康倫理委員會(Health Ethics Committee)

HEC成立于成立于2020年,是一個在健康領(lǐng)域發(fā)揮指導(dǎo)、決策功能的論壇,針對健康產(chǎn)品、健康研究或與健康有關(guān)的組織決策等領(lǐng)域產(chǎn)生的倫理問題提供指導(dǎo),保護(hù)谷歌用戶和產(chǎn)品的安全。HEC是一個綜合性的論壇,其中包括生物倫理學(xué)、臨床醫(yī)學(xué)、政策、法律、隱私、合規(guī)、研究和商業(yè)方面的主題專家。2021年,谷歌生物倫理項(xiàng)目創(chuàng)建了the Health Ethics Cafe,這是一個討論生物倫理問題的非正式論壇,公司任何人在項(xiàng)目開發(fā)的任何階段都可以在此進(jìn)行討論,論壇中遇到的棘手問題將被升級到HEC進(jìn)行審查。

(4)產(chǎn)品審查委員會(Product Area AI Principles Review Committees)

PAAPRC是一個專門為特定產(chǎn)品領(lǐng)域而設(shè)立的審查委員會。其中包括谷歌云的負(fù)責(zé)任AI產(chǎn)品委員會(Responsible AI Product Committee)和交易審查委員會(Responsible AI Deal Review Committee),其旨在確保谷歌云的AI產(chǎn)品、項(xiàng)目以系統(tǒng)、可重復(fù)的方式與谷歌人工智能原則保持一致,并將道德、責(zé)任嵌入了設(shè)計(jì)過程中。產(chǎn)品委員會專注于云人工智能和行業(yè)解決方案(Cloud AI & Industry Solutions)所構(gòu)建的產(chǎn)品。根據(jù)AI原則對社會技術(shù)前景、機(jī)會以及危害進(jìn)行綜合審查,并與跨職能、多樣化的委員會進(jìn)行現(xiàn)場討論,從而形成一個可操作的協(xié)調(diào)計(jì)劃。交易審查委員是一個由四名跨職能的高級執(zhí)行成員組成的委員會。所有決定的作出都必須得到所有四名委員會成員的完全同意,并根據(jù)需要逐步升級。谷歌AI原則生態(tài)系統(tǒng)的相關(guān)人員會幫助委員會了解討論的內(nèi)容,避免其憑空做出決定。

人工智能治理結(jié)構(gòu)的第三層是先進(jìn)技術(shù)審查委員會(Advanced Technology Review Council),這是一個由高級產(chǎn)品、研究和商業(yè)主管輪流擔(dān)任委員的委員會,代表著谷歌公司多個部門的不同意見。ATRC處理升級問題以及最復(fù)雜的先例性案例,并建立影響多個產(chǎn)品領(lǐng)域的策略,權(quán)衡潛在的商業(yè)機(jī)會和某些應(yīng)用程序的道德風(fēng)險。

案例一:谷歌云的負(fù)責(zé)任AI產(chǎn)品審查委員會&谷歌云負(fù)責(zé)任AI交易審查委員會為避免加重算法不公平或偏見,決定暫停開發(fā)與信貸有關(guān)的人工智能產(chǎn)品

2019年,谷歌云的負(fù)責(zé)任AI產(chǎn)品審查委員會評估了信用風(fēng)險和信譽(yù)領(lǐng)域的產(chǎn)品。雖然我們希望有一天AI能夠進(jìn)入信貸領(lǐng)域,并在增進(jìn)金融普惠和財(cái)務(wù)健康方面發(fā)揮作用,但產(chǎn)品審查委員會最終否定了這項(xiàng)產(chǎn)品——用當(dāng)下的技術(shù)、數(shù)據(jù)打造的信用可靠性產(chǎn)品,可能在性別、種族和其他邊緣化群體方面產(chǎn)生差別影響,并與谷歌“避免創(chuàng)造或加強(qiáng)不公平的偏見”的人工智能原則相沖突。2020年年中,產(chǎn)品審查委員會重新評估并重申了這一決定。在過去的一整年中,交易審查委員會評估了多個與信貸評估有關(guān)的人工智能應(yīng)用(proposed custom AI engagements)。每一項(xiàng)應(yīng)用都會根據(jù)其特定的用例進(jìn)行評估,交易審查委員會最終決定拒絕進(jìn)行其中的許多業(yè)務(wù)。多年的經(jīng)驗(yàn)和教訓(xùn)讓我們確信:在風(fēng)險得到適當(dāng)緩解之前,應(yīng)該暫停開發(fā)與信貸相關(guān)的定制AI解決方案(custom AI solutions)。這個方針從去年開始生效,并一直持續(xù)到今天。

案例二:先進(jìn)技術(shù)審查委員會基于技術(shù)問題與政策考量,拒絕通過面部識別審提案

2018年,先進(jìn)技術(shù)審查委員會處理了谷歌云產(chǎn)品的審查提案,決定在解決重大技術(shù)、政策問題之前,不提供通用面部識別API,并建議團(tuán)隊(duì)專注于專用AI解決方案。隨后,公司內(nèi)外相關(guān)人員對此進(jìn)行了大量的投入,經(jīng)過團(tuán)隊(duì)的多年努力,谷歌云開發(fā)了一個高度受約束的名人專用API2(Celebrity Recognition API2),并尋求ATRC的批準(zhǔn),最終ATRC同意發(fā)布該產(chǎn)品。

案例三:先進(jìn)技術(shù)審查委員會對涉及大型語言模型的研究進(jìn)行審查,認(rèn)為其可以謹(jǐn)慎地繼續(xù)

2021年,先進(jìn)技術(shù)審查委員會審查的其中一個主題是關(guān)于大型語言模型的發(fā)展。審查之后,先進(jìn)技術(shù)審查委員會決定,涉及大型語言模型的研究可以謹(jǐn)慎地繼續(xù),但在進(jìn)行全面的人工智能原則審查之前,此模型不能被正式推出。

三、技術(shù)工具

(1)Fairness Indicators:2019年發(fā)布,用于評估產(chǎn)品的公平性。Min-Diff14 technique:對日益增多的產(chǎn)品用例進(jìn)行補(bǔ)救,以達(dá)到最佳的學(xué)習(xí)規(guī)模,能夠主動解決公平性問題。

(2)federated learning:在Gboard等產(chǎn)品中使用的聯(lián)邦學(xué)習(xí),幫助模型根據(jù)真實(shí)的用戶交互進(jìn)行集中訓(xùn)練和更新,而無需從個人用戶那里收集集中的數(shù)據(jù),以增強(qiáng)用戶隱私。

(3)federated analytics:使用與federated learning類似的技術(shù),在不收集集中數(shù)據(jù)的情況下,深入了解產(chǎn)品特性和模型對不同用戶的性能。同時,federated analytics也允許項(xiàng)目團(tuán)隊(duì)在不訪問原始用戶數(shù)據(jù)的情況下進(jìn)行公平性測試,以增強(qiáng)用戶隱私。

(4)federated reconstruction:與模型無關(guān)的方法,可以在不訪問用戶隱私信息的情況下,實(shí)現(xiàn)更快、大規(guī)模的聯(lián)邦學(xué)習(xí)。

(5)Panda:一種機(jī)器學(xué)習(xí)算法,幫助谷歌評估網(wǎng)站的整體內(nèi)容質(zhì)量,并相應(yīng)地調(diào)整其搜索排名。

(6)Multitask Unified Model (MUM):使搜索引擎理解各種格式的信息,如文本、圖像和視頻,并在我們周圍世界的概念、主題和想法之間建立隱含的聯(lián)系。應(yīng)用MUM不僅將幫助世界各地的人們更高效地找到他們所需要的信息,而且還將增強(qiáng)創(chuàng)造者、出版商、初創(chuàng)企業(yè)和小企業(yè)的經(jīng)濟(jì)效益。

(7)Real Tone:為深色膚色的用戶提供了人臉檢測、自動曝光和自動增強(qiáng)等功能,幫助人工智能系統(tǒng)發(fā)揮更好性能。

(8)Lookout:一款為盲人和低視力者開發(fā)的安卓應(yīng)用程序,使用計(jì)算機(jī)視覺技術(shù)提供用戶周圍的環(huán)境信息。

(9)Project Relate:使用機(jī)器學(xué)習(xí)來幫助有語言障礙的人更便利地交流以及使用科技產(chǎn)品。

(10)Privacy Sandbox:與廣告行業(yè)合作,在支持出版商、廣告商和內(nèi)容創(chuàng)造者的同時,通過AI技術(shù)增強(qiáng)用戶隱私,提供更私密的用戶體驗(yàn)。

四、產(chǎn)品與服務(wù)

(1)Google Cloud:為各行業(yè)大規(guī)模應(yīng)用可信賴AI模型,提供可靠的基礎(chǔ)設(shè)施與高效的部署方案,并配套提供員工培訓(xùn)、集成相關(guān)開發(fā)環(huán)境等服務(wù),使得各行業(yè)人員能更便捷地掌握和使用可信賴的AI工具模型。

(2)TensorFlow:世界上最流行的ML框架之一,擁有數(shù)百萬的下載量和全球開發(fā)者社區(qū),它不僅在谷歌中被使用,而且在全球范圍內(nèi)被用來解決具有挑戰(zhàn)性的現(xiàn)實(shí)世界問題。

(3)Model Cards:一種情景假設(shè)分析工具,能夠?yàn)锳I的算法運(yùn)作提供一份可視化的解釋文檔。該文檔能夠?yàn)槭褂谜唛喿x,使其充分了解算法模型的運(yùn)作原理和性能局限。從技術(shù)原理上看,模型卡片設(shè)置的初衷是以通俗、簡明、易懂的方式讓人類看懂并理解算法的運(yùn)作過程,其實(shí)現(xiàn)了兩個維度的“可視化”:一是顯示算法的基本性能機(jī)制;二是顯示算法的關(guān)鍵限制要素。

(4)Explainable AI:借助該服務(wù),客戶可以調(diào)試和提升模型性能,并幫助他人理解客戶的模型行為。還可以生成特征歸因,以在 AutoML Tables 和 Vertex AI 中進(jìn)行模型預(yù)測,并利用 What-If 工具以直觀的方式調(diào)查模型行為。

五、治理創(chuàng)新:重視員工培訓(xùn)

相比于其他企業(yè),谷歌在AI倫理實(shí)踐方面的一大特色是專為員工開設(shè)了科技倫理培訓(xùn)(Technology ethics training),該培訓(xùn)項(xiàng)目旨在通過科技哲學(xué)來指導(dǎo)員工遵循道德,使他們了解如何評估潛在的利害,同時還配有課程,為員工解釋谷歌人工智能原則和內(nèi)部治理實(shí)踐。不僅如此,2021年,谷歌還為新員工配套了AI原則和負(fù)責(zé)任創(chuàng)新培訓(xùn)課程(AI Principles and responsible innovation training course),幫助他們了解谷歌的倫理道德準(zhǔn)則和可用資源。2021年,谷歌還推出了在線互動答題(interactive online puzzles),旨在幫助員工建立對人工智能原則的認(rèn)識,并測試他們的記憶程度。

一、倫理原則

IBM針對AI倫理問題提出了三大原則、五大支柱。三大原則分別是:人工智能的目的是增強(qiáng)人類的智慧、數(shù)據(jù)和觀點(diǎn)都屬于它們的創(chuàng)造者、技術(shù)必須是透明和可解釋的。五大支柱分別是:公平性、可解釋性、魯棒性、透明性、隱私性。

二、治理機(jī)構(gòu)

IBM在AI倫理踐行方面主要由AI倫理委員會(AI Ethics Board)負(fù)責(zé),公司AI治理框架的所有核心內(nèi)容均處于AI倫理委員會之下。委員會負(fù)責(zé)制定指導(dǎo)方針,并為人工智能的設(shè)計(jì)、開發(fā)和部署工作保駕護(hù)航,旨在支持整個公司的所有項(xiàng)目團(tuán)隊(duì)執(zhí)行AI倫理原則,并敦促公司和所有員工堅(jiān)守負(fù)責(zé)任AI的價值觀。

該委員會是一個跨學(xué)科的中央機(jī)構(gòu),委員會成員包括來自公司各個部門的代表,針對業(yè)務(wù)部門、科研部門、營銷部門、宣傳部門等部門的工作制定決策。此外,委員會還幫助業(yè)務(wù)部門了解對技術(shù)特征的預(yù)期,幫助公司各部門在AI倫理領(lǐng)域做到相互熟悉和了解,以便更好地開展協(xié)作。

同時,AI倫理委員會還將依據(jù)公司AI原則、具體核心內(nèi)容以及技術(shù)特征,審查業(yè)務(wù)部門可能向客戶提供的新產(chǎn)品或服務(wù)的提案。審查未來可能與客戶達(dá)成的交易時,委員會主要關(guān)注以下三個方面:首先是技術(shù)特征,其次是技術(shù)的應(yīng)用領(lǐng)域,最后是客戶本身,即審查客戶以往是否妥善遵循負(fù)責(zé)任AI原則。

案例一:新冠疫情期間,AI倫理委員會參與數(shù)字健康通行證開發(fā)、部署階段的評審工作。

為協(xié)助新冠疫情治理,IBM制定了數(shù)字健康通行證(Digital Health Pass)。該通行證的開發(fā)團(tuán)隊(duì)從最早的概念階段開始,就向委員會征詢意見,該通行證是。 通用的“疫苗護(hù)照(vaccine passports)”可能導(dǎo)致隱私問題或不公平的訪問,因此IBM的解決方案是:只有在個人同意后才能共享個人信息,并使每個人都受益。 委員會參與了開發(fā)階段,并在部署解決方案時繼續(xù)進(jìn)行評審。

三、技術(shù)解決方案

IBM根據(jù)AI倫理的五大支柱:可解釋性、公平性、魯棒性、透明性、隱私性,提出了五種針對性的技術(shù)解決方案。相應(yīng)的,它們分別是:AI Explainability 360 toolkit、AI Fairness 360 toolkit、Adversarial Robustness 360 Toolbox v1.0、AI FactSheets 360、IBM Privacy Portal。

(1)AI Explainability 360 toolkit:從普通人到政策制定者、從科研人員到工程技術(shù)人員,不同的行業(yè)和角色需要各不相同的可解釋性。為了有效解決可解釋性多樣性、個性化的強(qiáng)烈需求,IBM的研究人員提出了集成可解釋性工具箱AI Explainability 360(AIX360)。這一開源工具箱涵蓋了八種前沿的可解釋性方法和兩個維度評價矩陣。同時還提供了有效的分類方法引導(dǎo)各類用戶尋找最合適的方法進(jìn)行可解釋性分析。

(2)AI Fairness 360 toolkit:人工智能算法中的偏差問題越來越受到關(guān)注,AI Fairness 360是解決這一問題的開源解決方案。該工具提供了算法,使開發(fā)人員能夠掃描最大似然模型,以找到任何潛在的偏見,這是打擊偏見的一個重要工作,當(dāng)然也是一項(xiàng)復(fù)雜的任務(wù)。

(3)Adversarial Robustness 360 Toolbox v1.0:ART最初于2018年4月發(fā)布,是一個對抗性機(jī)器學(xué)習(xí)的開源庫,為研究人員和開發(fā)人員提供最先進(jìn)的工具,以在對抗性攻擊面前防御和驗(yàn)證人工智能模型。ART解決了人們對人工智能日益增加的信任擔(dān)憂問題,特別是在關(guān)鍵任務(wù)應(yīng)用中人工智能的安全性。

(4)AI FactSheets 360:以AI事實(shí)清單為代表的自動化文檔是增強(qiáng)AI可解釋性的重要方式,它能夠以一種清晰明了的方式,作為技術(shù)人員與使用者的溝通介質(zhì),從而能避免許多情形下的道德和法律問題。AI事實(shí)清單并不試圖解釋每個技術(shù)細(xì)節(jié)或公開有關(guān)算法的專有信息,它最根本的目標(biāo)是在使用、開發(fā)和部署AI系統(tǒng)時,加強(qiáng)人類決策,同時也加快開發(fā)人員對AI倫理的認(rèn)可與接納,并鼓勵他們更廣泛地采用透明性可解釋文化。

四、行動指南

IBM發(fā)布了《人工智能日常倫理指南》(Everyday Ethics for Artificial Intelligence),用于貫徹落實(shí)IBM提出的AI倫理道德原則。該指南旨在讓人工智能系統(tǒng)的設(shè)計(jì)者和開發(fā)人員系統(tǒng)地考慮AI倫理問題,將道德、倫理貫徹在AI的全生命流程中。

一、治理機(jī)構(gòu)

META團(tuán)隊(duì)(Machine Learning Ethics, Transparency & Accountability):這是一個由公司內(nèi)部的工程師、研究人員和數(shù)據(jù)科學(xué)家組成的專門小組,主要工作是評估公司使用的算法造成或可能造成的無意傷害,并幫助Twitter確定待處理問題的優(yōu)先級。META團(tuán)隊(duì)致力于研究人工智能系統(tǒng)的工作原理,并改善人們在Twitter上的體驗(yàn),比如刪除一種算法,讓人們對自己發(fā)布的圖片有更多的控制權(quán),或者當(dāng)這些圖片對某個特定社區(qū)產(chǎn)生巨大影響時,Twitter會制定新的標(biāo)準(zhǔn)來設(shè)計(jì)和制定政策。META團(tuán)隊(duì)工作的成果可能并不總是轉(zhuǎn)化為可見的產(chǎn)品變化,但在機(jī)器學(xué)習(xí)的構(gòu)建和應(yīng)用上給我們帶來更高層次的認(rèn)知,并對重要問題作出討論。

案例一:對性別和種族偏見的深入研究

META團(tuán)隊(duì)正在對圖像裁剪算法中的性別和種族偏見進(jìn)行“深入分析和研究”,其中包括對圖像裁剪(顯著性)算法的性別和種族偏見分析,對不同種族亞群體的“主頁”時間線推薦內(nèi)容進(jìn)行公平性評估以及針對七個國家不同政治意識形態(tài)的內(nèi)容推薦分析。

二、治理創(chuàng)新:算法賞金挑戰(zhàn)賽

頗有意思的是,為解決ML圖像裁剪的公平性問題,Twitter舉辦算法賞金挑戰(zhàn)賽,使用社區(qū)主導(dǎo)的方法來構(gòu)建更好的算法,收集來自不同群體的反饋。2021 年 8 月,Twitter舉辦了第一次算法偏見賞金挑戰(zhàn)賽,并邀請邀請人工智能開發(fā)者社區(qū)來拆解算法,以識別其中的偏見和其他潛在危害。算法賞金挑戰(zhàn)賽幫助公司在短時間內(nèi)發(fā)現(xiàn)了算法對于不同群體的偏見問題,成為公司征求反饋和了解潛在問題的重要工具。

在這樣一個新技術(shù)新應(yīng)用新業(yè)態(tài)以指數(shù)級增長的數(shù)字化時代,由于技術(shù)與人之間的交互和相互影響不斷加深,以及技術(shù)越來越具有更高的自主性,技術(shù)倫理成為了數(shù)字商業(yè)倫理的最新命題。正如微軟總裁兼副董事長布拉德·史密斯在其著作《工具,還是武器?》中所言,”如果你掌握了能夠改變世界的科技,那么你就有責(zé)任幫助解決你創(chuàng)造的世界所面臨的問題。”我國的相關(guān)頂層政策文件和立法都對科技倫理提出了新的要求,強(qiáng)調(diào)科技倫理審查的重要性,塑造科技向善的文化理念。在這樣的背景下,微軟、谷歌、IBM、Twitter等國外科技公司在AI倫理和可信AI上的實(shí)踐做法,可以提供很多有意義的啟發(fā)。

其一,在一個高度技術(shù)化、數(shù)字化的社會,在公司的治理版圖上,技術(shù)倫理將成為與財(cái)務(wù)、法務(wù)等既有板塊同等重要甚至更為重要的板塊。我們看到,技術(shù)倫理作為商業(yè)倫理的新拼圖,越來越多的科技公司開始將首席倫理官、倫理委員會等機(jī)制內(nèi)化為常態(tài)化的組織架構(gòu),統(tǒng)籌推進(jìn)相關(guān)工作。

其二,AI倫理和可信AI需要系統(tǒng)化的建設(shè),抽象的原則和頂層的框架固然重要,但行勝于言,更重要的是將倫理原則轉(zhuǎn)化為具體的實(shí)踐,融入技術(shù)設(shè)計(jì)以打造負(fù)責(zé)任的技術(shù)應(yīng)用。在這方面,內(nèi)部治理機(jī)制、技術(shù)解決方案、倫理培訓(xùn)、倫理黑客社區(qū)(類似于網(wǎng)絡(luò)安全領(lǐng)域的白帽黑客)、技術(shù)標(biāo)準(zhǔn)等傳統(tǒng)的和創(chuàng)新性的方式日益發(fā)揮出重要作用。因?yàn)榭尚臕I和AI倫理不僅是理念原則,更是行動路線。

其三,正如可信AI和AI倫理的概念本身所表征的那樣,我們需要反思技術(shù)人員主導(dǎo)的技術(shù)研發(fā)應(yīng)用和部署過程,更多強(qiáng)調(diào)技術(shù)開發(fā)應(yīng)用中的多元背景和多元參與。將政策、法律、倫理、社會、哲學(xué)等領(lǐng)域的人員引入開發(fā)團(tuán)隊(duì),是將倫理要求嵌入技術(shù)設(shè)計(jì)開發(fā)的最直接的、最有效的路徑。好的技術(shù)不僅關(guān)注結(jié)果,更要關(guān)注過程。

科技向善是高度技術(shù)化社會的終極愿景。科技向善(tech for good)的理念至少包括兩個路徑,向外需要用技術(shù)解決各種社會問題挑戰(zhàn),向內(nèi)需要關(guān)注技術(shù)本身,打造“善的/好的技術(shù)”(good tech)。AI倫理和可信AI正是聚焦于如何打造“善的/好的技術(shù)”,最終為向外發(fā)力的“科技向善”建立基礎(chǔ)。

[1]https://www.microsoft.com/en-us/ai/responsible-ai?activetab=pivot1%3aprimaryr6

[2]https://www.microsoft.com/en-us/ai/our-approach?activetab=pivot1%3aprimaryr5

[3]https://www.microsoft.com/en-us/ai/responsible-ai-resources

[4]https:://azure.microsoft.com/en-us/solutions/devops/devops-at-microsoft/one-engineering-system/

[5]https://ai.google/responsibilities/

[6]https://cloud.google.com/responsible-ai

[7]https://www.tensorflow.org/responsible_ai

[8]https://blog.tensorflow.org/2020/06/responsible-ai-with-tensorflow.html

[9]https://github.com/microsoft/responsible-ai-toolbox

[10]https://www.ibm.com/artificial-intelligence/ethics

[11]https://aix360.mybluemix.net/?_ga=2.38820964.651461218.1639109085-1605157021.1638780204

[12]https://www.ibm.com/blogs/research/2019/09/adversarial-robustness-360-toolbox-v1-0/

[13]https://blog.twitter.com/en_us/topics/company/2021/introducing-responsible-machine-learning-initiative

[14]https://blog.twitter.com/engineering/en_us/topics/insights/2021/algorithmic-bias-bounty-challenge

本文來自微信公眾號 “騰訊研究院”(ID:cyberlawrc),作者:曹建峰、梁竹,36氪經(jīng)授權(quán)發(fā)布。